Manchester from Kersal Moor, William Wyld, 1852

Alors que la puissante de la plupart des grandes I.A. statistiques et en particulier génératives ne progresse quasiment que de manière brute, par l’augmentation de la taille des corpus de données d’entraînement aussi bien que par par celle de la puissance de calcul, il est légitime de se demander si ces méthodes ont un impact écologique significatif, notamment en consommation énergétique mais aussi de ressources naturelles, et si cet impact est notoirement différent du monde numérique précédent le « boum » des I.A. du début des années 2020.

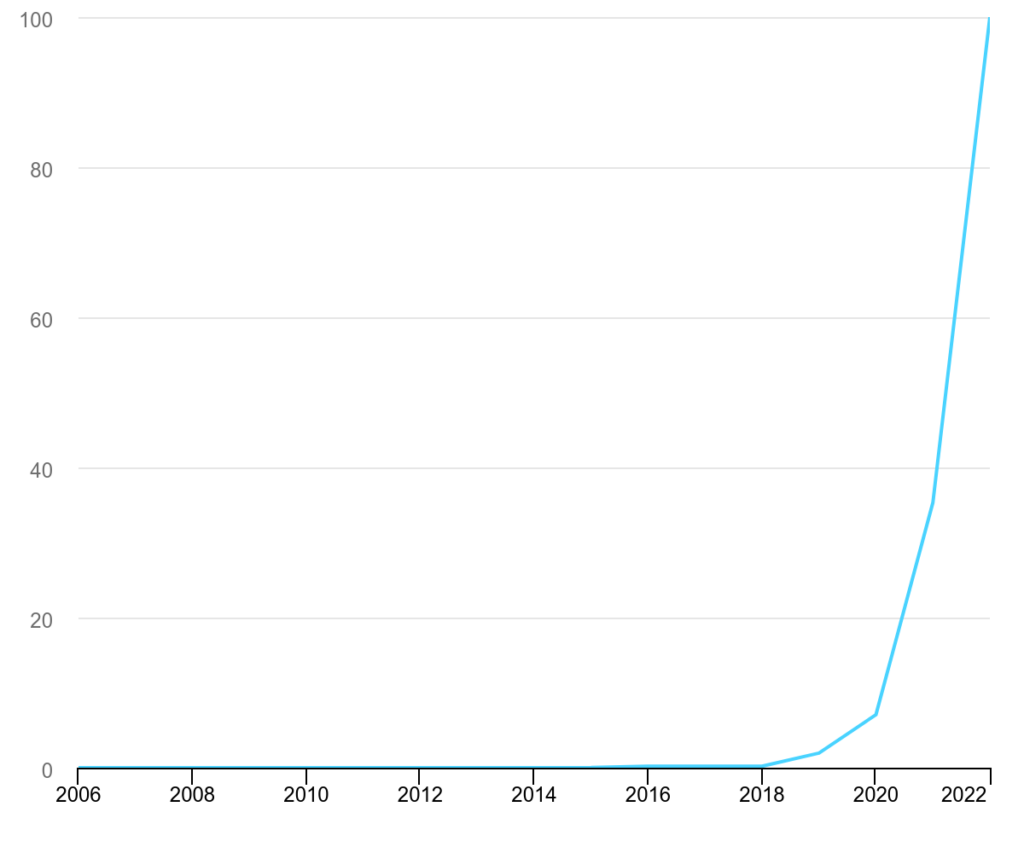

Taille et complexité des modèles d’intelligence artificielle.

2006-2022, IEA, Paris, Licence: CC BY 4.0

Malheureusement, les données fiables sur le sujet sont particulièrement difficiles à trouver ; les entreprises développant des I.A. statistiques ne laissent filtrer que peu, ou pas, d’informations. Les chiffres qu’on peut trouver en ligne sont souvent des estimations au doigt mouillé, et, ou, biaisées. Après une revue assez large des informations sur le sujet, on peut cependant proposer une méthode de calcul et un ordre de grandeur des valeurs de consommation diverses. Toutes les informations disponibles ici sont sourcées et recoupées entre elles, les ordres de grandeurs et valeurs attendues en fonction de différents modes de calculs sont comparés pour s’assurer de la cohérence des articles et études retenues pour ce résumé. J’ai écarté plusieurs sources et estimations fantaisistes ou au doigt mouillé, notamment souvent celles concernant les consommations « par requète » ou « par prompt », lorsque les ordres de grandeur n’ont aucune cohérence avec les consommations énergétiques des serveurs et le poids des services numériques en général, et ne recoupent pas les estimations globales de l’agence internationale de l’énergie (IEA)1.

En résumé

Afin de rendre tous ces chiffres abstraits un peu plus concrets, nous allons les comparer les consommations aux consommations énergétiques annuelles totales de ma propre maison, 85 m2 dans les Alpes2, d’approximativement 4000 kWh3 en 2024 (les années où il ne fait pas trop froid, donc), c’est à dire une puissance moyenne d’environ 450 W.

Consommation électrique

Voici les ordres de grandeur des consommations d’énergie liées à l’I.A. Le détail du calcul ainsi que les sources d’information sont disponibles plus bas.

- Processeur pour l’I.A.4 : 350 W à 750 W en moyenne, et jusque 1000 W.

Un processeur dédié à l’I.A. dans un serveur informatique peut consommer jusque 1000 W (en incluant les périphériques et autres composants nécessaires à son fonctionnement). Les processeurs n’étant pas utilisés à plein régime en permanence, on peut raisonnablement faire des estimations sur une fourchette large de 350 à 750 W. C’est la consommation moyenne de ma maison. Pour un seul processeur. - Grand centre de calcul et de données dédié à l’I.A. : de 500 MW à 2 GW.

Les centres tels que ceux construits par Meta, OpenAI, Alphabet/Google et d’autres grandes entreprises (avec des soutiens publics, et aussi en Europe) comportent plus d’un million de processeurs. Et consomment donc l’équivalent de plus d’un million de maisons comme la mienne, ou encore la production d’un ou deux réacteurs nucléaires. - Consommation annuelle mondiale des centres de données : 460 TWh en 2022, jusque 1000 TWh prévus en 2026.

C’est l’équivalent de 1 à 2,5 fois la consommation de toute la France ou celle de tout le Japon, qui sont classés dans le top 10 des pays les plus énergivores, bien qu’étant de tous petits pays. Cette augmentation de la consommation des centres de données est bel et bien tirée par l’usage de l’intelligence artificielle5.

Il faudrait ajouter à cette consommation celle liée à la fabrication des processeurs, qui s’élève au minimum à des dizaines de térawatts-heure supplémentaires, voire des centaines.

Consommation d’eau

Les données sur la consommation en eau sont encore plus difficiles à réunir. Voici toutefois des ordres de grandeur crédibles. Le détail et les sources sont disponibles plus bas.

- Consommation annuelle mondiale pour le refroidissement des serveurs d’I.A. : 4,2 à 6,6 Gm3 prévus en 2027.

C’est l’équivalent de toute la consommation d’eau potable en France. - Fabrication des serveurs : des centaines de millions de mètres cubes par an.

Oui mais…

Voici quelques arguments entendus qui tendent à relativiser l’impact environnemental de l’intelligence artificielle statistique, et les réponses qui peuvent y être apportées.

Mais l’I.A. va aider à réduire les impacts environnementaux

Selon les géants et moins géants de la tech, l’usage de l’intelligence artificielle a le potentiel d’améliorer les processus de fabrication, de production, de transport de potentiellement toutes les industries et services, et par cette montée en efficacité de réduire leurs impacts environnementaux. C’est là un argument fortement teinté de technosolutionnisme, mais penchons-nous un instant dessus.

L’argument est facile à énoncer, mais sans étude d’impact valable, il reste un vœu pieux. On ne peut que constater qu’au jour où ces lignes sont écrites, l’intelligence artificielle ne fait qu’exploser les consommations énergétiques du numérique.

Un chiffre souvent avancé est celui d’une réduction des émissions globales de CO2 de 5 à 10 % grâce à l’I.A., si elle était appliquée à toutes les émissions, c’est-à-dire une réduction de 2,6 à 5,3 Gt par an. Ces chiffres sont en fait tirés d’un article6 publié par Boston Consulting Group (BCG), un cabinet de conseil dont le marché est constitué de clients qui justement développent et utilisent des I.A. On note d’ailleurs que BCG promeut le fait de « Déployer l’I.A. Générative dans les outils de tous les jours »7. Bref, on peut légitimement douter de l’objectivité du cabinet ayant compilé ces chiffres, à partir des usages (non représentatifs) de ces clients… Quand bien même, si l’I.A. était appliquée à toutes les émissions (ce qui est déjà une condition difficile à remplir), la vraie question serait de savoir si ces 2 à 3 gigatonnes économisées compenseraient les nouvelles émissions liées à l’I.A., ce qui est très loin d’être évident.

Il semble qu’une simple requête « traditionnelle » sur le moteur de recherche Google, sans usage d’intelligence artificielle, émette environ 0,2 g de CO2. À raison de seulement 10 millions de requêtes par jour (une estimation du nombre de requêtes quotidiennes sur ChatGPT) ; si on transpose cette valeur à ChatGPT, on obtient des émissions de 2 mégatonnes quotidiennes, soit 0,73 gigatonne annuelle rien que pour cette I.A. en particulier, déjà un tiers de ce qui est censé être économisé. Notons que même si cette valeur de 0,2 g de CO2 par requête pour Google est probablement sur-estimée, l’ordre de grandeur des émissions du numérique et de l’I.A. est bien équivalent à ce qu’elle est censée faire économiser.

Mais il faudrait aussi ajouter, à ces émissions calculées sur la base actuelle, les augmentations induites par l’effet rebond et le paradoxe de Jevons, connu déjà depuis le 19ᵉ siècle, mais que les entreprises de la tech font mine d’ignorer.

Ce paradoxe énonce qu’à mesure que les améliorations technologiques augmentent l’efficacité avec laquelle une ressource est employée, la consommation totale de cette ressource peut augmenter au lieu de diminuer. En particulier, ce paradoxe implique que l’introduction de technologies plus efficaces en matière d’énergie peut, dans l’agrégat, augmenter la consommation totale de l’énergie. Il a été observé déjà tout au long de l’histoire de l’automatisation du travail, et explique justement pourquoi la quantité de travail humain ne baisse pas malgré cette automatisation8.

Il est applicable dans cet exemple aussi bien directement à l’I.A.9 qu’aux industries qui en profiteraient pour améliorer leur efficacité énergétique, et conduirait directement à une forte augmentation des consommations globales et, entre autres impacts environnementaux, une amplification du réchauffement climatique.

On peut conclure en notant simplement que les économies potentielles liées à l’usage de l’I.A. ne compenseront certainement pas les augmentations de consommation qu’il provoquera, bien au contraire.

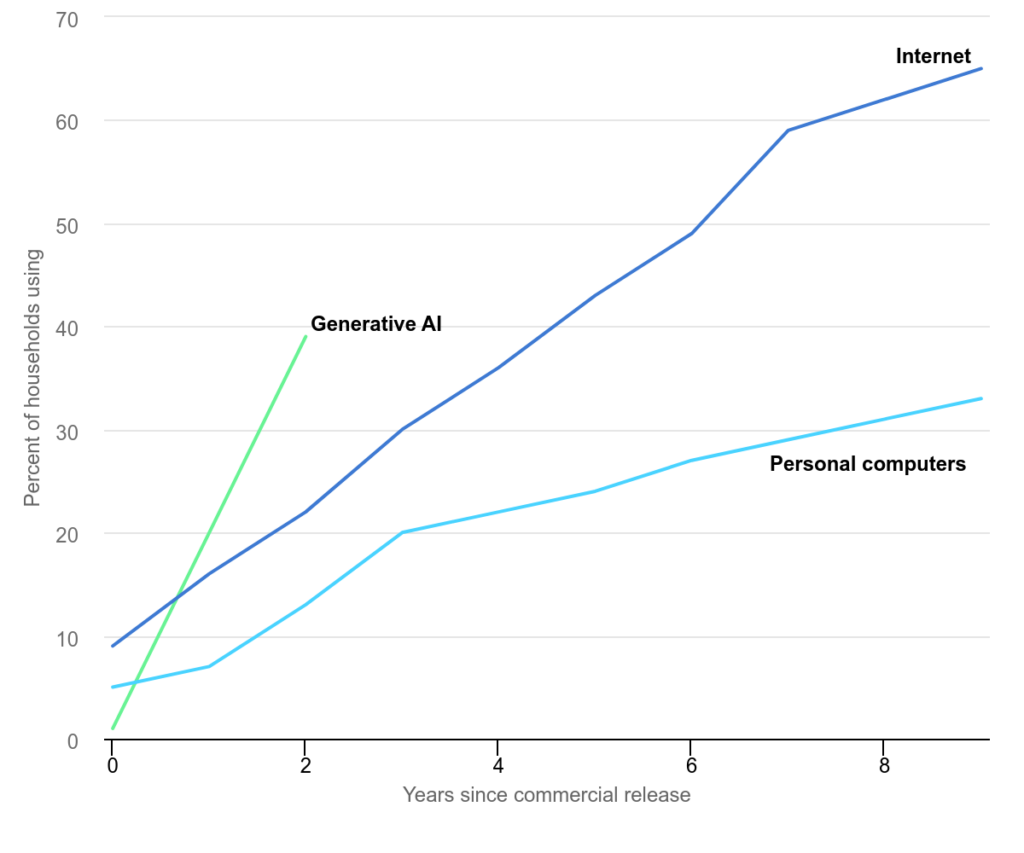

Comparaison du taux d’adoption dans les foyers des technologies numériques aux États-Unis.

IEA, Paris, Licence: CC BY 4.0

Mais l’IA remplace d’autres usages numériques

Selon cet argument, l’I.A. ne viendrait que remplacer des usages numériques pré-existants, comme la recherche, la fabrication de certaines images…

On peut rapidement réfuter l’argument : l’usage de l’intelligence artificielle consomme au bas mot dix fois plus que les usages numériques pré-existants, et c’est encore une fois sans compter l’effet rebond que nous avons expliqué juste au-dessus, et les nouveaux usages qui l’accompagnent…

Mais ce n’est que de l’électricité, qui peut être « verte »

Il est faux de réduire les consommations de l’intelligence artificielle à de l’électricité, quand le refroidissement et la fabrication des serveurs sont de grands consommateurs d’eau et de matières premières.

Cela étant dit, la production d’électricité alimentant l’I.A. est loin d’être verte, et n’est pas près de l’être ; la France produit la majorité de son électricité grâce à la fission nucléaire10, qu’il serait erroné de considérer comme complètement « décarbonée »11, et elle est une exception mondiale. La grande majorité de la production de l’électricité à l’échelle mondiale provient des énergies fossiles ; et des entreprises pétrolières comme Shell constatent déjà une augmentation de la demande en gaz naturel liquéfié12, en partie liée à l’intelligence artificielle. Si plusieurs grands acteurs de l’I.A. investissent dans le nucléaire dans une vaine tentative de se décarboner, la grande majorité de leurs consommations provient bien des énergies fossiles.

Mais ces consommations sont relativement faibles comparées à tous les autres secteurs d’activité

Dans les grandes économies comme la Chine, l’Union Européenne, le Royaume Uni et les États-Unis, la consommation des centres de données représente 2 à 4 % de la demande globale en électricité, et 1 % dans le monde entier, en 2022, donc juste avant le « boum » de l’I.A. Ces proportions sont sur une progression franchement montante. Ce qui n’est tout de même par rien.

Ces chiffres généraux cachent des problématiques locales, alors que les centres de données sont généralement regroupés. Il en résulte par exemple que dans cinq états des États-Unis la consommation des centres de données à déjà dépassé 10 % de la consommation totale d’électricité en 2024, et même 20 % en Irelande. Avec le développement de ces centres de données, il faut s’attendre à des tensions considérables sur les réseaux locaux, et la réponse à cette demande via des énergies fossiles ne peut que faire manquer les objectifs de transition énergétique régionaux13.

Des consommations énergétiques

La phase d’entraînement des I.A. est généralement vue comme un processus borné dans le temps, avec une fin bien définie, et qui représente donc relativement peu d’énergie (bien que les chiffres soient déjà déments) en comparaison des consommations de l’inférence (la phase d’usage) que nous décrivons plus loin.

ChatGPT-3 rapporte avoir utilisé 1287 MWh pour son entraînement, soit l’équivalent de la consommation annuelle de 320 maisons comme la mienne (ou l’équivalent d’une heure de la production d’un réacteur nucléaire). Il faut noter que 90 % de l’énergie consommée durant cette phase provient du mouvement des données14, entre le lieu de stockage et celui de traitement, et non pas directement de la puissance de calcul en elle-même… Les données concernant les modèles plus récents, ChatGPT-4 et suivants ne sont pas disponibles. Il faut noter d’ailleurs que l’apprentissage de ChatGPT-4 ne se termine vraiment jamais : il est entraîné régulièrement afin de pouvoir apporter des réponses plus actuelles à ses utilisateurs.

Il faut bien comprendre qu’en réalité les acteurs de l’I.A. continuent en permanence d’entraîner leurs modèles et de nouveaux modèles. Plutôt que d’essayer d’estimer d’un côté la consommation liée à l’apprentissage et de l’autre celle de l’inférence, nous pouvons nous pencher directement sur la taille et la consommation des serveurs dédiés à l’I.A. en général.

Pour les calculs de consommation de ces serveurs, il est utile d’avoir ces quelques données en tête :

- Une unité de serveur dédié à l’I.A. consomme entre 6000 et 10000 W.15 ; chaque unité de serveur contient 8 processeurs dédiés à l’I.A.

Comme les entreprises de l’I.A. parlent plus volontiers en nombre de processeurs que de serveurs, on peut retenir qu’un processeur nécessite environ jusqu’à 1000 W pour son fonctionnement. Étant donné que les processeurs ne sont pas utilisés en permanence à 100 % de leur capacité, on peut raisonnablement diviser ce chiffre par deux ou trois, ce qui permet d’estimer une consommation de 350 à 500 W minimum pour chaque processeur (et pouvant donc monter théoriquement jusqu’à 1000W).

Prenons encore comme exemple ChatGPT-3 dont les données étaient publiques ; avec 3617 serveurs NVIDIA HGX A100, soit 28936 processeurs16, on peut estimer sa puissance approximative à 14 MW, c’est-à-dire approximativement 10 % de celle d’un réacteur nucléaire ou la consommation de 31000 maisons comme la mienne… Notez bien que la génération de texte a une consommation très, très inférieure à celle de la génération d’images et à plus forte raison de vidéo.

Mais ce sont là des chiffres à minima, qui ne représentent pas les usages réels des entreprises de l’I.A. Ces sociétés étant toutefois fières de la démesure des centres de données qu’elles construisent, elles communiquent régulièrement sur ces constructions et le nombre de processeurs graphiques qu’elles contiennent. Meta, maison mère de Facebook, a ainsi annoncé atteindre 1,3 million de processeurs ; ce qui permet d’en déduire une puissance approximative liée à l’I.A. de 650 MW (au minimum), autrement dit la consommation de 1,4 million de maisons comme la mienne ou la puissance d’un petit réacteur nucléaire. Meta indique en fait produire 1,5 GW d’électricité en partenariat avec l’entreprise Entergy, apparemment produite en brûlant du gaz naturel17. Dans la course à la puissance, Alphabet/Google, OpenAI, Mistral, annoncent tous des constructions de serveurs dans ces ordres de grandeur. À eux seuls, on atteint facilement entre 5 et 10 GW de puissance, ce qui représente tout de même entre 45 et 90 TWh en un an, au bas mot, équivalent à 10 à 20 % de la consommation électrique de toute la France, soit la production d’une dizaine de réacteurs nucléaires.

D’après l’agence internationale de l’énergie, la consommation mondiale des centres de données en 2022 est estimée à 460 TWh, une valeur supérieure à la consommation électrique de toute la France cette année-là (420 TWh)18. Et cette consommation en pleine croissance devrait franchir les 1000 TWh en 2026 (soit la consommation annuelle (actuelle) du Japon, ou deux fois et demi celle de la France, qui sont tous deux dans le top 10 mondial des consommations électriques), tirée majoritairement par l’I.A.

Il faut bien remarquer aussi que ces chiffres sont bels et biens très supérieurs à ceux des consommations « habituelles » du numérique. John Hennessy, président d’Alphabet19, indique qu’utiliser un robot conversationnel pour la recherche internet consommerait « 10 fois plus qu’une recherche standard par mots clefs »20. Alors qu’une recherche sur Google consommerait (au moins) 0,3 Wh21, cela suggère une consommation d’environ 3 Wh pour chaque interaction avec un robot conversationnel. Or, cette comparaison, sous-estimée22, ne se fait que sur le remplacement d’un usage existant par un autre, alors que les consommations liées à l’I.A. sont aussi le fait nouveaux usages, loin, très loin d’être tous nécessaires ou indispensables, et qui, comme la génération d’image, peuvent encore consommer bien plus.

Des consommations de ressources naturelles

Outre les consommations liées à l’énergie (très majoritairement issue des ressources fossiles) citées précédemment, il faut aussi prendre en compte l’impact de l’I.A. sur les ressources naturelles, en métaux et matériaux nécessaires à la fabrication des serveurs, ainsi qu’en eau pour leur refroidissement.

Les consommations en eau sont difficiles à estimer et peuvent varier d’un serveur à un autre en fonction de la méthode utilisée. Bien que ces consommations soient gardées secrètes, une étude de l’université de Californie23 révèlerait que l’entrainement de ChatGPT-3 aurait évaporé à lui tout seul 700000 litres d’eau, et plus généralement qu’il faut s’attendre à 4,2 à 6,6 milliards de mètres cubes d’eau utilisée pour le refroidissement l’I.A. dans le monde en 2027. C’est l’équivalent de toute la consommation d’eau potable en France, ou de toute la consommation d’eau par l’industrie et l’agriculture réunie en France24.

À cela il faut ajouter la consommation en eau liée à la fabrication des semi-conducteurs qui font fonctionner ces I.A. Là encore, il est impossible de réunir des données précises, mais on sait que cette consommation est loin d’être négligeable.

Si on ne sait pas quelle part de semi-conducteurs sont dédiés à l’I.A., on sait que cette industrie en général est une grande consommatrice d’eau et d’énergie. Une étude chinoise de 202325 nous apprend qu’elle a consommé 789 millions de mètres cubes d’eau en 2021, et 149 TWh d’énergie. De cette consommation en eau, 96,6 % est de l’eau douce et seulement 3,2 % sont recyclés. Plus précisément, 47 % est de l’eau douce de surface, 35,3 % provient des réseaux municipaux et 8,5 % des nappes phréatiques.

La production de ces semi-conducteurs, les « puces » informatiques, et l’un des processus de fabrication industrielle les plus complexes de l’histoire, qui va de l’extraction et la transformation du silicium (qui peut être du sable, des mines de quartz…) à son assemblage en couches dans des puces de plastique ou de céramique, en passant par la gravure nanométrique, et l’ajout de composants nécessitant des dizaines de métaux différents, plus ou moins rares (arsenic, tantale, titane, antimoine, gallium…) et divers produits chimiques et plastiques notamment. Au final, une puce « neuve » a déjà parcouru l’équivalent de 2,5 fois le tour de la terre et franchi 80 frontières26.

- Executive Summary – Electricity 2024 – Analysis, 2024, IEA. ↩︎

- Estimation incluant le chauffage, l’eau chaude, et le télé-travail sur ordinateur. ↩︎

- Rappel sur les unités : le watt (W) est une unité de puissance instantannée, tandis que le wattheure (Wh) est une quantité d’énergie consommée ; 1 Wh représente l’énergie consommée par un appareil d’une puissance de 1 W en une heure. Les multiples utilisés en fonction des ordres de grandeurs sont le kilo (kW, kWh) pour mille ; le méga (MW, MWh) pour un million ; le giga (GW, GWh) pour un milliard ; le téra (TW, TWh) pour mille milliards. ↩︎

- Ce qu’on nomme ici « Processeur pour l’I.A. » sont en fait des GPU, des processeurs graphiques, originellement dédiée au calcul d’images mais aussi utilisés en intelligence artificielle statistique, en particulier depuis 2012. ↩︎

- Chiffres : Executive Summary – Electricity 2024 – Analysis, 2024, IEA.

Lire aussi : Artifial Intelligence – Topics, IEA. ↩︎ - Reduce Carbon and Costs with the Power of AI, 2021, BCG. ↩︎

- Artificial Intelligence at Scale, BCG. ↩︎

- Why Are There Still So Many Jobs? The History and Future of Workplace Automation, David H. Autor, Journal of Economic Perspectives, vol. 29, no. 3, Summer 2015 ↩︎

- The Demand Elasticity Paradox: More than Meets the AI, Tabrez Syed, Medium. ↩︎

- Qui elle-même amène son lot de problèmes : déchets radioactifs, coût du démantèlement des centrales en fin de vie, coût de construction des centrales de nouvelle génération… ↩︎

- Le chantier de construction des nouveaux réacteurs autant que le futur démantèlement des anciens réacteurs sont loin d’être « décarbonés ». ↩︎

- La demande mondiale de GNL augmentera plus que prévu, selon Shell, Sciences et Avenir, AFP. ↩︎

- Artifial Intelligence – Topics, IEA. ↩︎

- L’intelligence artificielle, un véritable gouffre énergétique, Science et Avenir, 11 janvier 2025. ↩︎

- Par exemple, le DGX A100 a une consommation maximale de 6,5 kW, et le DGX H100 de 10,2 kW (données techniques NVIDIA). ↩︎

- The Inference Cost Of Search Disruption – Large Language Model Cost Analysis, SemiAnalysis. ↩︎

- Meta announces 4 million sq ft, 2GW Louisiana data center campus, Data center dynamics. ↩︎

- Chiffres clés de l’énergie, ministère de la Transition écologique. ↩︎

- La maison mère de Google. ↩︎

- Reuters, Focus: For tech giants, AI like Bing and Bard poses billion-dollar search problem ↩︎

- D’après le post de blog officiel de Google, Powering a Google search. ↩︎

- Cette valeur est dans la fourchette basse des estimations qu’on peut faire avec les informations accessibles à propos des grands modèles de langages tels que ChatGPT, qui varient entre 4 et 9 Wh par requête (selon les calculs d’Alex de Vries dans son article The growing energy footprint of artificial intelligence paru dans Joule). Une fourchette qui semble raisonnable, étant donné que Google a certainement tendance à sous-estimer son propre impact environnemental et les coûts de l’I.A. ↩︎

- Making AI Less « Thirsty »: Uncovering and Addressing the Secret Water Footprint of AI Models, avril 2023, arXiv:2304.03271 ↩︎

- L’eau en France : ressource et utilisation – Synthèse des connaissances en 2024, ministère de la Transition écologique. ↩︎

- Environmental data and facts in the semiconductor manufacturing industry: An unexpected high water and energy consumption situation, Water Cycle, 2023 ↩︎

- How are semiconductors made?, European Semiconductor Industry Association. ↩︎

Laisser un commentaire