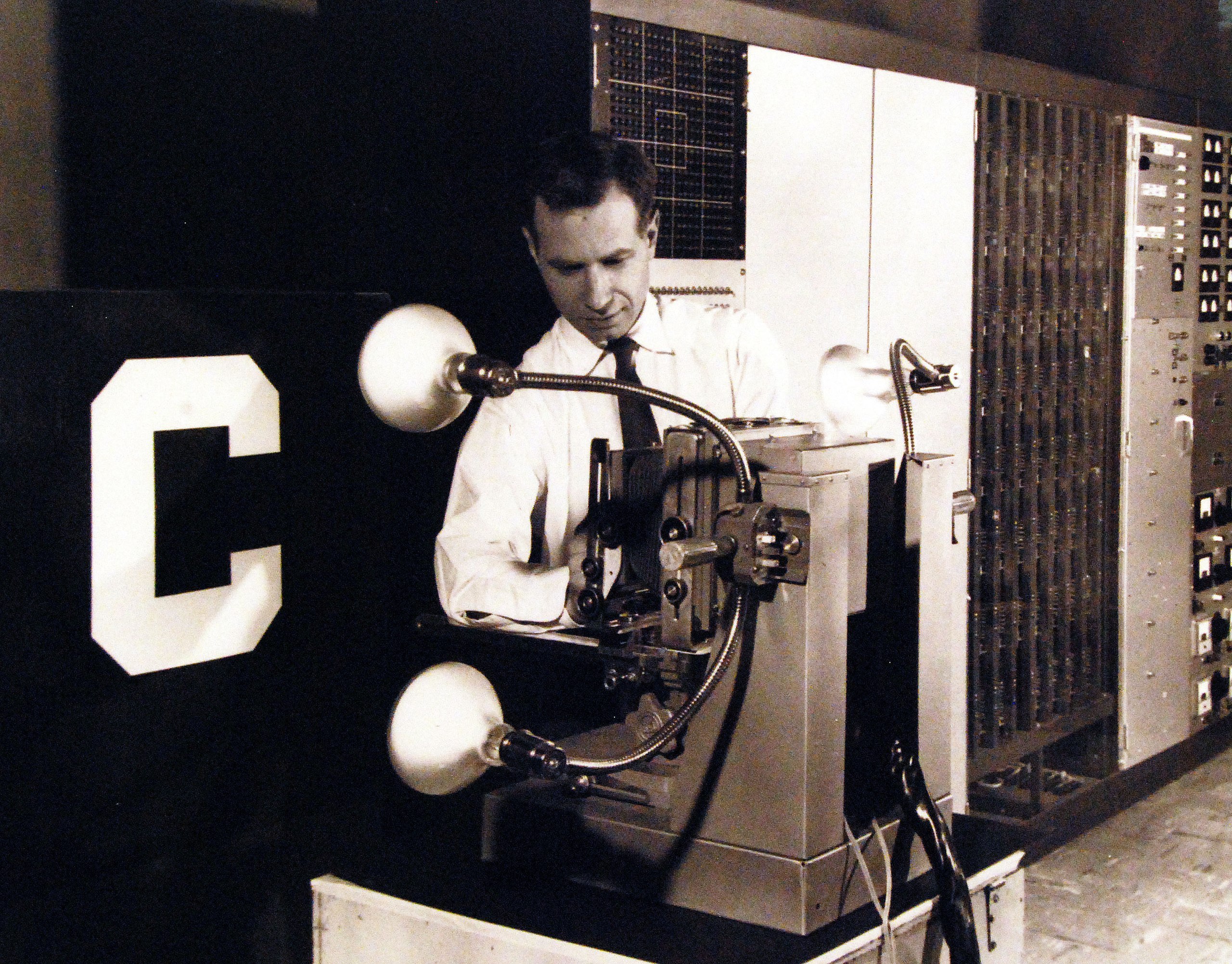

330-PSA-80-60 (USN 710739): Experimental Machine Able To Identify Letters of Alphabet Announced By Navy.

Avant l’informatique

Alors que le terme Intelligence Artificielle est introduit par John McCarthy1 en 1956, le concept est déjà exploré aussi bien par la science-fiction que la philosophie. On note d’ailleurs à travers l’histoire de la philosophie le lien intime entre la formalisation du raisonnement, de la logique et des démonstrations, et la création de machines et d’automates, précurseurs lointains de l’ordinateur et de l’intelligence artificielle.

Cette histoire passe notamment par l’Ars Magna (le « Grand Art ») de Raymond Lulle2, une machine faite de roues, leviers et cadrans pouvant démontrer la vérité d’un postulat via un système de logique formelle, dès le 13è siècle. Quatre siècles plus tard, Leibniz3, notamment créateur de la première machine à calculer effectuant les quatre opérations arithmétiques de base, poussera l’idée plus loin en imaginant à la fois un langage universel, la characteristica universalis, et une machine, le calculus ratiocinator, programmable pour déterminer et démontrer n’importe quel résultat logique

(et donc philosophique, pour le rationaliste qu’était Leibniz), n’importe quelle vérité, absolue et universelle. Cette caractéristique universelle est la racine de la logique moderne, qui continue d’évoluer4 jusque la naissance de l’informatique lors de la seconde guerre mondiale. Cette universalité du langage inspirera à la fois l’Esperanto5, et sous son aspect logique, le langage de programmation Prolog6, encore en usage au 21è siècle.

Dès 1936, Alan Turing imagine un modèle abstrait dans le but de donner une définition précise au concept d’algorithme, de « procédure mécanique » ;

autrement dit une représentation abstraite des machines à calculer en tous genres mais aussi des futurs ordinateurs : c’est la machine de Turing.

Au delà du développement et de la formalisation de la logique, l’idée de modéliser et reproduire l’intelligence naît de la volonté d’étudier le problème corps-esprit7, et de la compréhension nouvelle au 20è siècle du fonctionnement du cerveau. Cette exploration passe notamment par l’analyse du fonctionnement indivuel des neurones. En 1943, Walter Pitts8 et Warren McCulloch9 écrivent Un calcul logique des idées immanentes dans l’activité nerveuse10, où ils décrivent le fonctionnement discret, binaire, des neurones, avec deux états possibles (activés ou désactivés) en fonction de multiples entrées. Les neurones sont donc capables de réaliser un calcul logique, sur le même principe binaire que le fonctionnement des « portes logiques » fondamentales des ordinateurs dont le développement commence à la même époque. Malgré de nombreux présupposés ensuite démentis, cet article inspirera grandement la conception des premiers ordinateurs. Pitts et McCulloch proposent aussi le premier modèle mathématique de ce fonctionnement logique des neurones, qui sera la future base des réseaux de neurones artificiels. Dès son origine, le développement des ordinateurs se fait avec l’idée de mimer le fonctionnement des neurones et du cerveau, plus ou moins simplifié. Il est notable que Warren McCulloch a aussi établi que lorsqu’un neurone A est relié à un neurone B, il existe aussi toujours une liaison allant de B vers A. Cette propriété peut aussi être rapprochée de techniques utilisées à partir des années 1970 en intelligence artificielle11.

Le recueil de nouvelles Les Robots d’Isaac Asimov12 est publié en 1950, dans lequel il introduit ses fameuses trois lois dites de la robotique13. C’est aussi en 1950 qu’Alan Turing publie Computing Machinery and Intelligence, article dans lequel il propose son fameux test pour évaluer l’intelligence apparente d’une machine14. Il est intéressant, et utile pour la suite, de noter à quel point dès l’origine, notamment par ce test, l’I.A. est indissociable de la linguistique.

Dès leurs origines séculaires, le développement de l’informatique et de l’intelligence artificielle, quelle qu’en soit la définition qu’on en fait aujourd’hui, sont indissociables. John McCarthy, pionnier de l’informatique et des langages de programmation, à l’origine même de l’expression « intelligence artificielle » en 1956, définit l’intelligence artificielle ainsi : « la science de l’ingénierie de la fabrication de machines intelligentes, en particulier de programmes informatiques intelligents. Elle est liée à la tâche similaire qui consiste à utiliser des ordinateurs pour comprendre l’intelligence humaine, mais l’IA ne doit pas se limiter aux méthodes qui sont biologiquement observables. »15 Définir l’intelligence serait un sujet trop vaste pour ce qui nous occupe ici. Notons simplement qu’il n’y a pas de définition de l’intelligence qui ne dépendrait pas de l’intelligence humaine16, ce qui explique aussi bien l’importance du domaine de la linguistique que de la biologie dans le développement de l’intelligence artificielle.

Tout comme l’on peut distinguer deux catégories de processus cognitifs pour la résolution des problèmes par l’humain, deux voies sont rapidement explorées pour le développement de l’intelligence artificielle dès les années 1960 : des méthodes analytiques et déterministes, basées sur la logique, qui formeront des intelligences artificielles dites symboliques, et des méthodes qui s’inspireront notamment du fonctionnement des neurones et de leur apprentissage formant des intelligence artificielles dites statistiques.

La logique

D’un côté les méthodes algorithmiques, où les solutions sont les résultats d’un enchainement déterministe de raisonnements logiques, c’est à dire où des problèmes identiques, posés selon des termes équivalents aboutiront à des solutions identiques. Là où ces processus chez l’humain sont fortement basés sur le

langage et semblent dépendre du langage lui même, leur pendant informatique est le résultat de l’usage de langages de programmation, et d’une méthode analytique nécessitant une connaissance humaine préalable du problème.

Le premier programme informatique qu’on pourrait qualifier d’intelligence artificielle est conçu ainsi. C’est Logic Theorist17 en 1956, dont le but est de reproduire les compétences de résolution de problèmes de l’être humain, et notamment de prouver des problèmes mathématiques18. Il sera notamment suivi en 1966 par le célèbre ELIZA19 qui simule une conversation avec un psychothérapeute, et aborde l’intelligence artificielle sous le prisme du test de Turing.

L’apprentissage automatique

De l’autre côté les méthodes statistiques, prenant des raccourcis, qu’on pourrait qualifier d’instinctives chez l’humain, autrement plus compliquées à modéliser, notamment sur un ordinateur, machine de Turing par essence déterministe, logique et mathématique. Ces méthodes, nécessitant un apprentissage statistique

au lieu d’une analyse symbolique, permettent une résolution plus rapide des problèmes, au prix d’une fiabilité, d’une rationnalité réduite. Dans ce cas, des problèmes identiques peuvent amener à des solutions différentes, et les raisonnements ne sont pas nécessairement reproductibles. Ne dépendant pas du langage, c’est à un niveau plus bas des processus cognitifs qu’il faut s’intéresser pour les comprendre et les reproduire artificiellement, et c’est en observant le

fonctionnement des neurones que l’informatique peut aborder le problème.

Ces méthodes sont indissociables de phénomènes de mémorisation, de ce qu’on appelle aussi l’expérience chez l’humain, et font aussi souvent intervenir des facteurs aléatoires.

Ce travail commence dès 1957 avec le Perceptron, inventé par Frank Rosenblatt20 (note biographique), qui remet en cause la capacité du calcul logique binaire, booléen, à reproduire l’intelligence humaine. Le Perceptron est un

algorithme, et un programme informatique, modélisant un neurone formel, c’est à dire une représentation mathématique d’un neurone biologique. Il possède plusieurs entrées (correspondant aux dendrites – les

connexions – d’un neurone biologique) et une seule sortie, un résultat unique (correspondant à l’état actif ou inactif du neurone biologique tel que décrit dès

1943 par Pitts et McCullogh). Les valeurs en entrée sont pondérées, ce qui permet l’apprentissage, la mémorisation encodée dans le poids donné à chacune des

entrées. Le Perceptron permet aussi de munir ce neurone formel d’une règle permettant de déterminer ces poids automatiquement, aboutissant ̀a une forme d’apprentissage automatique21 qu’on appelle l’apprentissage supervisé.

Ce concept de neurone formel est ̀a la base de tous les systèmes d’apprentissage modernes sur lesquels sont construites les intelligences artificielles statistiques. C’est en les combinant qu’on crée des réseaux de neurones (des Perceptrons multicouches). Dans un tel réseau, les neurones sont regroupés en couches, contenues entre les neurones ̀a l’entrée et ceux à la sortie. En augmentant le nombre de neurones et le nombre de couches, on peut alors augmenter la complexité des données en entrée, et donc la complexité des problèmes à

résoudre, à condition d’avoir la puissance de calcul nécessaire à disposition, en particulier lors de la phase d’apprentissage, durant laquelle les poids a affecter aux connexions entre les neurones sont inférés. Si le nombre de couches de neurones est élevé (supérieur

à quelques unes), on parle d’apprentissage profond22.

C’est en 1959 qu’Arthur Samuel23 introduit l’expression « machine learning », « apprentissage automatique » en français, parfois aussi traduit plus littéralement en

« apprentissage machine », notamment pour décrire son programme de Jeu de Dames conçu chez IBM.

Une première machine dédiée à ce mode de calcul et d’apprentissage est rapidement créée, capable de reconnaître des images numériques monochromes, les neurones en entrée lisant les valeurs allumées ou éteintes de chaque pixel. Alors que les développeurs veulent appliquer le principe à la reconnaissance de texte, la marine américaine, qui finance les recherches, les oriente vers la reconnaissance aérienne.

Mais cette voie se heurte rapidement à des problèmes d’échelle et d’apprentissage : si toutes ces techniques

prometteuses sont rapidement développées, elles restent relativement inefficaces en raison du nombre de neurones nécessaires pour obtenir des résultats significatifs et au manque de puissance de calcul de l’époque, et à la difficulté même de collecter suffisamment de données.

Suite ̀a la publication d’un article sévère en 1969, Perceptrons, écrit par Marvin Minsky24 et Seymour Papert25, ce domaine de recherche entre dans une

phase dite « hiver de l’intelligence artificielle ». Selon Minsky et Papert, imiter un cerveau est trop compliqué, cette méthode empiriste, partant de la perception pour aller vers la pensée, n’est pas la bonne ; ils préconisent une voie rationnaliste, celle des idées, des raisonnements appliqués, de la logique, via les languages de programmation. Ces deux voies sont en concurrence, aussi bien intellectuelle que financière, toutes deux dépendant des subventions de l’armée américaine26. Sans être complètement abandonnée, la recherche autour des réseaux de neurones ralentit fortement jusqu’aux années 2000.

En 1997, la très médiatisée victoire de Deep Blue, ordinateur d’IBM, sur Garry Kasparov, champion mondial d’échecs, inspire nombre d’autres projets, en particulier Watson, toujours chez IBM, qui gagne le jeu Jeopardy!27 en 2011. Deep Blue a ceci de particulier qu’il utilise originellement une intelligence artificielle symbolique, logique, qui « connaît » et applique les règles du jeu ; mais l’immense nombre de combinaisons possibles aux échecs ne permettant pas à l’ordinateur de pouvoir prévoir tous les coups possibles malgré 200 millions de coups analysés par seconde, il faut lui apporter des méthodes heuristiques. On lui adjoint alors une mémoire de plusieurs milliers d’ouvertures28, ainsi que d’un grand nombre de fins de parties possibles à 6 pièces, et toutes les fins possibles avec moins de pièces. Pour la partie principale du jeu, une analyse statistique est effectuée sur plusieurs centaines de milliers de parties de grands maîtres.

Quelques équipes scientifiques s’intéressant au fonctionnement du cerveau et de la conscience creusent

aussi l’idée de simuler le cerveau au moyen de neurones virtuels. Par exemple, dans une étude en 200729, une équipe fait tourner une simulation d’un million de neurones et un demi milliard de synapses, modélisant seulement une partie de cerveau humain. La simulation prend alors une minute pour simuler chaque seconde réelle, après dix minutes d’initialisation du modèle.

Mais ces différentes expérimentations se limitent à des problèmes très restreints30, surtout relativement à leurs coûts, à la fois par manque de données d’apprentissage et par manque de puissance de calcul pour aller vers des applications plus générales.

Il faut attendre les années 2010 et le web 2.0 pour obtenir un accès plus facile à une quantité gigantesque de données, et notamment que se forme un « data-business » entretenu par les collecteurs gargantuesques que sont les réseaux sociaux en tous genres, les moteurs de recherche, et plus généralement les acteurs de la publicité et de la consommation en ligne, y compris les plateformes vidéo. En 2012, un réseau de neurones développé par Google parvient à reconnaître des visages humains et des chats dans des vidéos sur la plateforme

YouTube.

Le boum de l’I.A.

C’est aussi en 2012 qu’a été développée une nette amélioration de la puissance calcul, avec AlexNet, le premier réseaux de neurones fonctionnant grâce ̀a des processeurs graphiques, originellement spécialisés dans le traitement des pixels, et qui permettent de nombreux calculs en parallèle ; notons qu’AlexNet est un réseau neuronal convolutif, c’est à dire inspiré par le cortex visuel des mammifères, qui permet des économies de puissance de calcul grâce à un système de sous-échantillonnage des données. Cette méthode est, assez

logiquement, ̀a la base des programmes d’IA de reconnaissance d’image et de vidéo, mais aussi de systèmes de recommandations (pour plateformes de

vente en ligne ou de vidéo à la demande notamment) et de traitement du langage naturel.

En 2015, le but ultime du mouvement initié par Deep Blue en 1997 est atteint : AlphaGo, développé par Google, gagne contre un des meilleurs joueurs humains au jeu de Go, jeu de plateau considéré comme le plus difficile au monde.

Il n’aura ensuite fallu que quelques années pour atteindre une limite prévisible au développement de l’IA

statistique : les plus grandes IA, que ce soient les modèles de langage ou les IA générant des images, ont déjà été entrainées sur toutes les données disponibles sur internet. Parallèlement à l’augmentation de la puissance de calcul et de la mémoire des systèmes, on

commence donc à entrainer de nouvelles IA avec du contenu généré par d’autres IA ; par exemple en 2023, des chercheurs de Microsoft31 expliquent ainsi comment ils peuvent utiliser les résultats du plus grand modèle de langage du moment (ChatGPT-4) pour entrainer de plus petits modèles de langage et les faire parler anglais correctement.

Le 10 juin 2024, lors de sa conférence annuelle destinée aux développeurs, Apple présente les fonctionnalités utilisant l’IA, c’est à dire l’apprentissage profond et les grands modèles de langage tels que ChatGPT, dans ses systèmes d’exploitation (iOS pour mobiles et MacOS pour ordinateurs), actant l’intégration, imposée, de l’IA dans tout l’environnement numérique, ne faisant nul doute que les mêmes fonctionnalités de rédaction de texte, de géneration d’images, de synthèse, seront aussi

implémentées par Microsoft et Google dans leurs systèmes (Windows pour Microsoft, Android et Chrome pour Google), envahissant ainsi l’immense majorité des appareils numériques. C’est une parfaite illustration de ce « boum » de l’IA du début des années 2020 : un développement aussi rapide que possible, par la force, et une intégration imposée, pour des usages aussi indispensables que, par exemple, la génération d’émojis personnalisés, le trucage des photos de vacances, ou s’adresser à voix haute en langage naturel à son téléphone pour ouvrir une application et y copier du texte32… En étant ainsi capable de « lire » le contenu intégral de nos appareils numériques, de reconnaître les personnes sur nos photos, cette I.A. est aussi une nouvelle technique potentielle de récolte des données personnelles, perfectionnant ainsi le rôle premier des smartphones qui mériteraient encore plus leur surnom de

spyphones33.

En une dizaine d’années, l’I.A. statistique (en tant qu’apprentissage profond), est passée d’outil de recherche scientifique, à produit grand public, après avoir siphonné quasiment l’intégralité d’internet, s’entrainant ensuite elle même, et s’insinuant dans les objets du quotidien, par la volonté de grandes entreprises privées seules détentrices des ressources nécessaires à ce développement rapide.

- John McCarthy, 1927-2011 : mathématicien et informaticien étasunien, pionnier de l’intelligence artificielle avec Marvin Minsky, mettant en particulier l’accent sur la logique symbolique (en « opposition » à l’apprentissage automatique et la statistique). ↩︎

- Raymond Lulle, 1232-1315 : philosophe, théologien et missionnaire chrétien majorquais. Les principes de sa philosophie sont inséparables de son projet de conversion des musulmans et des juifs. ↩︎

- Gottfried Wilhelm Leibniz, 1646-1716 : philosophe, mathématicien, logicien allemand. Polymathe, et un des principaux représentant du rationalisme philosophique, avec Descartes et Spinoza. ↩︎

- Tissant une ligne qui va des syllogismes d’Aristote au travail de Georges Boole en 1847, passant donc par Leibniz et le travail de Emmanuel Kant sur la logique, et aboutissant sur l’informatique. ↩︎

- L’espéranto est une langue construite, conçue par Louis-Lazare Zamenhof, un ophtalmologue et linguiste à Varsovie, en 1887. Elle a pour but d’être une langue internationale et universelle, la lingvo internacia. ↩︎

- Prolog (acronyme de Programmation en Logique) est un langage de programmation été créé vers 1972 à Marseille. Le but était de créer un langage de programmation où seraient définies les règles logiques attendues d’une solution et de laisser le compilateur les transformer en séquence d’instructions. L’un des gains attendus était une facilité accrue de maintenance des applications, l’ajout ou la suppression de règles au cours du temps n’obligeant pas à réexaminer toutes les autres.

Prolog est utilisé en intelligence artificielle et dans le traitement linguistique par ordinateur. ↩︎ - Le problème corps-esprit est un questionnement philosophique concernant le type de relation que l’esprit entretient avec le corps, en particulier avec le cerveau. Bien que ce problème ait pu déjà se poser depuis les premiers développements de la philosophie, chez Platon notamment, et qu’il ait trouvé sa formulation moderne dès le 17è siècle, ce n’est que durant le 20è siècle qu’il est explicitement mis en avant comme une question fondamentale. En philosophie de l’esprit, le problème posé par la nature des relations entre l’esprit et le corps est en partie lié à la difficulté d’expliquer les relations qui existent entre les états physiques qui se réalisent dans le cerveau et les états mentaux qui relèvent de la conscience. ↩︎

- Walter Pitts, 1923-1969 : scientifique étasunien, dont les travaux sur l’activité neuronale ont notamment marqué et influencé les sciences cognitives et la psychologie, les neurosciences, mais aussi l’informatique, les réseaux de neurones artificiels, la cybernétique et l’intelligence artificielle… ↩︎

- Warren McCulloch, 1898-1969 : chercheur en neurologie étasunien, initiateur des rencontres interdisciplinaires, dites Conférences Macy, à l’origine de la cybernétique. ↩︎

- A Logical Calculus of Ideas Immanent in Nervous Activity ↩︎

- La rétropropagation du gradient, technique développée dans les années 1970 et 1980 permet d’affiner l’entrainement des réseaux de neurones en corrigeant les erreurs en mettant à jour les poids des connexions entre les neurones en partant de la dernière couche et en remontant vers la première couche. ↩︎

- Paru en anglais sous le tire I, Robot ↩︎

- – Première loi : Un robot ne peut porter atteinte à un être humain ni, restant passif, laisser cet être humain exposé au danger ;

– Seconde loi : Un robot doit obéir aux ordres donnés par les êtres humains, sauf si de tels ordres entrent en contradiction avec la première loi ;

– Troisième loi : Un robot doit protéger son existence dans la mesure où cette protection n’entre pas en contradiction avec la première ou la deuxième loi.

Au cours du cycle des livres sur les robots, Asimov ajoute une loi zéro, plaçant la sécurité de l’humanité avant celle des individus. Elle n’est pas codée au niveau matériel, à la différence des trois premières, mais est de type logiciel, puisque « déduite » par un robot. Elle est formulée ainsi :

– Un robot ne peut pas faire de mal à l’humanité, ni, par son inaction, permettre que l’humanité soit blessée. ↩︎ - Dans ce test, un sujet humain échange verbalement à l’aveugle avec un humain et un ordinateur. Si il n’est pas capable de dire lequel de ses interlocuteurs est un ordinateur, on considère que l’ordinateur (et son logiciel) a passé le test avec succès. Il reste toutefois une question philosophique non résolue : ce test de Turing évalue-t-il seulement l’apparence de l’intelligence, ou, comme le considère Turing, l’intelligence elle même ? ↩︎

- What is Artificial Intelligence? 2007, Stanford University ↩︎

- Ibid. ↩︎

- Programme informatique écrit en 1955 et 1956 par Allen Newell, Herbert Simon et Cliff Shaw. Il a été conçu pour reproduire les compétences de résolution de problèmes d’un être humain et est considéré comme le premier programme d’intelligence artificielle. Il a été capable de prouver 38 des 52 théorèmes des Principia Mathematica de Whitehead et Russell. ↩︎

- De nombreux assistants de preuve existent, développés dès les années 1950/1960, permettant la vérification de preuves mathématiques. Ces logiciels permettent à un humain de transcrire les étapes d’une démonstration mathématique dans un processus appelé formalisation. Grâce à elle, le logiciel peut ensuite vérifier la validité de la démonstration.

Le but de ces projets est de mettre à la disposition du mathématicien des outils informatiques pour l’aider à élaborer une version formelle du résultat auquel il s’intéresse. Le logiciel stocke aussi les résultats démontrés auparavant. ↩︎ - Développé par Joseph Weizenbaum entre 1964 et 1966, ELIZA simule un psychothérapeute rogérien en reformulant la plupart des affirmations du « patient » en questions, et en les lui posant. ↩︎

- Frank Rosenblatt, 1928-1971 : psychologue étasunien, principal représentant du courant neuronal, de l’intelligence artificielle statistique. ↩︎

- Machine learning, en anglais ↩︎

- Deep learning, en anglais ↩︎

- Arthur Samuel, 1901-1990 : informaticien étasunien, pionnier du jeu sur ordinateur, de l’intelligence artificielle et en particulier de l’apprentissage automatique. ↩︎

- Marvin Minsky, 1927-2016 : spécialiste étasunien des sciences cognitives et de l’intelligence artificielle, et philosophe. Cofondateur avec John McCarthy du

Groupe d’intelligence artificielle du Massachusetts Institute of Technology (MIT) ↩︎ - Seymour Papert, 1928-2016 : mathématicien et informaticien sud-africain, chercheur puis professeur au MIT, où il a créé le Groupe de Recherche sur l’Épistémologie et l’Apprentissage, il a aussi été une figure du socialisme révolutionnaire britannique lors de son séjour à Londres dans les années 1950. ↩︎

- Ce qui deviendra la DARPA, Defense Advanced Research Projects Agency, agence étasunienne chargée de la recherche et du développement de technologies militaires. ↩︎

- Jeu télévisé étasunien diffusé depuis 1964 où les candidats doivent deviner des questions à partir de réponses possibles. ↩︎

- Des listes des premiers coups possibles dans la partie d’échecs. ↩︎

- M. Izhikevich, Gerald M. Edelman, Large-scale model of mammalian thalamocortical systems, 4 mars 2008, PNAS – Proceedings of the National Academy of Sciences of the USA. ↩︎

- Des jeux avec des règles précises, des simulations limitées… ↩︎

- How Small Can Language Models Be and Still Speak Coherent English, Ronen Eldan, Yuanzhi Li, 24 mai 2023, arXiv:2305.07759 ↩︎

- Annonces faites par Apple lors de sa conférence du 10 juin 2024. ↩︎

- Spy signifie espion en anglais. ↩︎

Laisser un commentaire